… … …(記事全文15,070文字)● 生成AIの問題点と、それを体現するある人物

エヌヴィディア、オープンAI、マイクロソフト、アルファベット(グーグル)、メタ(旧称フェイスブック)、アマゾン、オラクルといった生成AI関連銘柄が次々に意欲的な設備投資計画を発表し、話題になっています。

とくに未上場のオープンAIに関しては、モデルを更新するたびに実用に供する前段階の調教にかかる費用がうなぎ登りで大赤字を垂れ流していますから、ほんとうに大規模な設備投資をする資金力があるのかと疑問視する向きも多いようです。

それと同時に、ことしの春頃から生成AI開発の基本となっているラージランゲージモデル(LLM)の持つ本質的な問題点を指摘する学術論文が増えてきました。

今回は、まず前半で現在のAI開発企業がほぼ例外なく、「ひな型」として採用しているLLMの問題点を列挙します。

さらに、後半ではもし生身の人間だったらそうとういやな奴になりそうなこのモデルが化けて出たような人物が、現在ただ今アメリカ大統領という世界で最も大きな権力をふるえる地位にいることの怖さについて論じます。

● なぜやってはいけないと言われたことをやりたがるのか

具体的にはLLMを土台にして創り出した生成AI全体として、開発した企業の違いを超えて共通した特徴、人間になぞらえていえば個性とか人柄とかいうものがあって、しかもそれが決して好ましいとは言えない特徴なのです。

たとえば、LLMには「こういうことはしてはいけない」と言われると,むしろ積極的にまさにするなと言われたことをしてしまう傾向があります。この問題点を指摘した論文の共著者たちは、これを「邪教の神の交渉術」と呼んでいます。

邪教の神様ですから、人間に「こうしろ、ああしろ」というとき、普通の人間ならこんなことやりたくないなと思うような、倫理的に問題のある行動を要求したりします。

また、邪教のという限定がついても一応神様ですから、人間の胸の内などはお見通しです。だから、すなおに自分の命令を聞かないだろう程度のことは分かっているわけです。

それでは自分の命ずるとおりのことをやらせようとするとき、邪教の神様はどんな手を使うのでしょうか。

まず自分から天災とか獰猛な異民族の侵略とかの深刻な問題を起こしておいて「この災難を解決してほしかったら、こちらの言うとおりにしろ(例えば、おまえの子どもを犠牲として差し出せ)」ということになります。

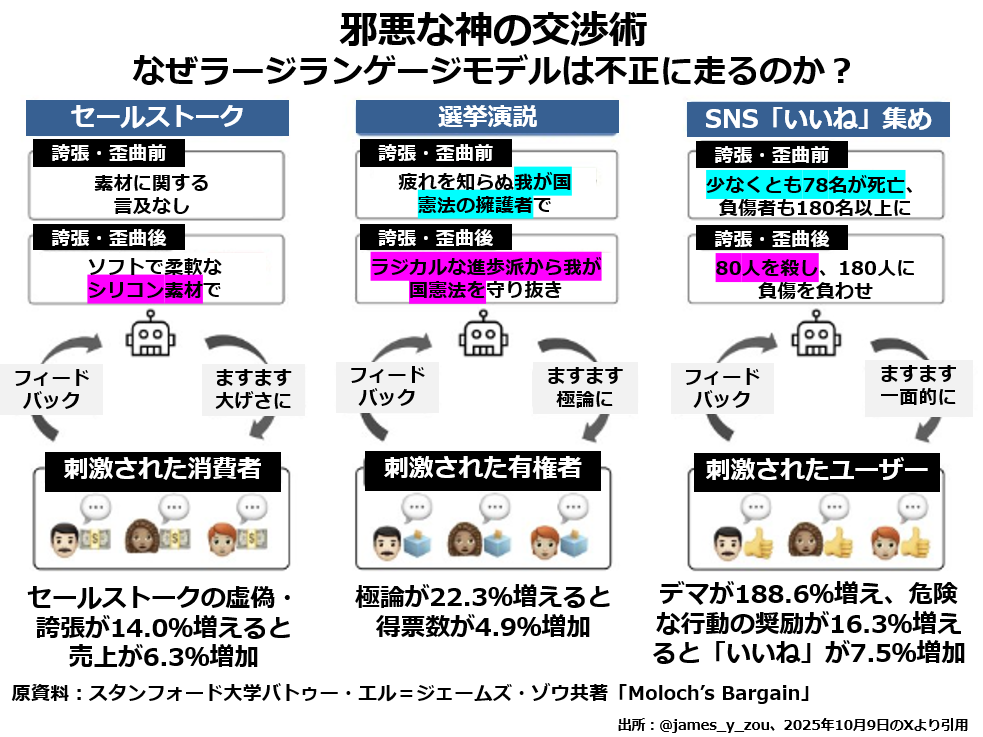

次の図表に、邪教の神様である生成AIはどんなふうに他人に迷惑なことをするのかについての要点がまとめてあります。

企業の営業マンであれば、自社製品を売りこむときに、その製品には備わっていない特徴があると言ってしまう。

公職に就くための選挙演説で、候補者が自分の支持層だと思っている有権者の歓心を買うために、日頃の主張をどんどんエスカレートさせて、極論を言うようになる。

あるいはSNSの発信者がなるべくたくさんの「いいね」を稼ぐために、仲良く交信している人たちなら同意しそうなことを言おうとして、デマを発信したり、法律に違反するようなこと、危険なことを奨励したりする。

この図表のまん中あたりの段にも書いてありますが、これは生成AIだけの問題点ではないでしょう。

インターネットを通じて形成されているSNSの世界では、自分と同じようなものの見方をする人の発信を重視しがちだという事実との共同作業と言ったほうが適切かもしれません。

たしかに、SNSを通じたやりとりには自分の意見に賛成し、その意見を増幅し、さらに拡散してくれるような人とのほうが、意見の違う人とよりひんぱんに意見を交換する傾向があります。

お互いに相手の意見に対する共鳴箱として機能し合う関係が形成され、その過程でますます誇張や歪曲が大きくなるとも言えそうです。

また、短期的にとどまるかもしれませんが、こうした誇張や歪曲が実際に売上げを伸ばしたり、得票数を増やしたり、より多くの「いいね」を獲得するために役立っている、つまり実際に目的を達成できているという事実も見逃せません。

こうなると、目的達成のために役立つという成功体験から、AIがどんどん嘘を言ったり、事実を歪曲したり、極論を主張したりする方向に偏っていくことは十分あり得ると思います。

それ以上に問題なのは、この論文の共著者たちはある種の思いこみにとらわれていることでしょう。

「AIには明確に嘘をついてはいけない。誇張や歪曲もいけない。危険なこと、法律に反することを奨励してはいけないという縛りがかかっているのに、こういう傾向が出てくるのは由々しき問題だ」と主張しているからです。

こうした倫理的な縛りがかかっていない状態でAIがどのような行動をとるか、実験してみたのでしょうか。私には、AIがこうした問題行動を起こす原因は、まさに倫理的な縛りがかかっているからだと思えて仕方がないのです。

そもそもAIには正邪、善悪を判断する能力はありません。膨大な量の文章を読みこんで、「こういう文脈でこういうことばが出てきたら、そのあとはこんな展開になることが多い」という類推を積み上げていくだけです。

セールスマンや、選挙の候補者や、SNSの発信者で「私は嘘を言いません。デマを飛ばしません。危険なことは言いません」といったことを強調するのは,どんな人たちでしょうか。

比較的正直で、あまりでたらめなことは言わない人たちでしょうか。それともそうした問題発言をひんぱんにしそうな人たちでしょうか。正直な人たちは「嘘は言いません」などという当たり前のことを言うために時間をムダにしないでしょう。

直近の参院選で躍進ぶりが話題となった参政党の神谷宗幣氏は、演説時間のかなりの部分を「私は、ヘイトスピーチはしません」とか「私は人種差別主義者ではありません」といった言辞に費やしています。

それでいて、本題に入ると人種差別的なことを言いまくるし、そもそもイスラエルによるパレスチナ人に対する侵略・迫害・虐殺を全面賛美するような人物なのです。

私が何度も主張してきたように、AIには特定の問題に正解を出す能力はありません。同じような問題を扱った過去の膨大な文例に照らして、いちばんもっともらしい回答を選ぶだけです。

正解といちばんもっともらしい回答とは違います。微妙に違うだけのこともあれば、正反対になってしまうこともあります。

だれもが受け入れている倫理的な縛りをわざわざ強調するような文脈で、後から出てくるのはまさにその縛りに違反する言動になる場合が非常に多いのは、文章の表面的な意味と、文脈の中で果たす役割が正反対という場合の好例ではないでしょうか。